하이퍼 바이저

하이퍼바이저(hypervisor)는 호스트 컴퓨터에서 다수의 운영 체제(operating system)를 동시에 실행하기 위한 논리적 플랫폼(platform)을 말한다. 가상화 머신 모니터(virtual machine monitor, 줄여서 VMM)라고도 부른다.

위키 백과에 따르면 하이퍼 바이저란 서버 가상화를 위한 일종의 소프트웨어라고 볼 수 있을 것 같습니다.

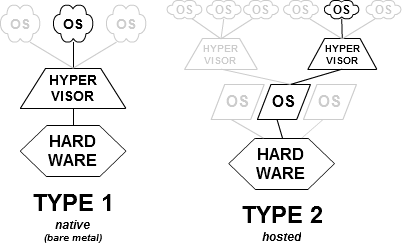

이러한 하이퍼 바이저는 두가지로 나뉩니다.

1. Type1 : native(bare metal) 방식

장점

단점

2. Type2 : hosted 방식

: 하이퍼바이저가 일반 프로그램처럼 host OS위에서 실행되며, 게스트 운영체제는 하이퍼 바이저 위에서 3번째 수준으로 실행됩니다.

서버가상화의 도입 요인

- 하드웨어 능력의 확대로 한 컴퓨터에서 동시에 작업할 수 있는 양이 증가하였다.

- 서버를 통합하여 비용이 줄고 관리를 간소화하였다.

- 서버 저장소나 렌더 저장소 같은 대규모 멀티프로세서와 클러스터 장비를 제어할 필요가 있었다.

- 하이퍼바이저 아키텍처로 인해 보안성, 신뢰성, 장비의 독립성이 증가하였다.

- 특정한 운영 체제에 의존적인 응용 프로그램을 다른 하드웨어나 운영 체제 환경에서 실행시킬 필요가 있었다.

서버 가상화

가상 머신의 정의

: 가상 컴퓨터 시스템을 의미

: 내부에 운영체제와 애플리케이션을 갖춘 완전히 분리된 소프트웨어 컨테이너

: 가상화 대상

: 서버, 스토리지, 네트워크, 앱...

가상 머신의 역할

: 단일 서버에서 하나 이상의 가상 시스템과 다수의 운영체제 및 애플리케이션을 실행할 수 있게됨

: 하이퍼 바이저를 이용

: 하이퍼 바이저 위에서 동작하는 운영체제의 기본단위를 가상머신이라고 부름

주요 속성

서버 통합

클라우드 컴퓨터와 다른 개념

: 클라우드 컴퓨터는 가상화를 통해 인터넷으로 공유 컴퓨팅 리소스를 온디맨드로 제공하는 것을 의미

가상화의 유형

: 서버 가상화

: 네트워크 가상화

: 물리적 네트워크를 소프트웨어로 완벽하게 재현

: 논리적 네트워킹 디바이스 및 서비스(논리적 포트, 스위치, 라우터, 방화벽, 로드 밸런싱장치, VPN 등) 을 제공

: 물리적 네트워크와 동일한 기능 및 성능을 보장하면서, 가상화 운영 이점과 하드웨어 독립성을 제공

: 데스크톱 가상화

장단점

: 장점

: 시스템을 더 빠르게 재구축할 수 있음

: 오래된 서버를 새것처럼 쓸 수 있음

: 고려할 점

: CPU, 코어, RAM, 디스크 공간의 한계 고려

: SQL서버에 시스템, 데이터, 로그 공간을 어떻게 별도로 할당할지?

: 백업과 복구 고려( 이부분은 레거시 시스템보다 더 유연)

: 즉, 하드웨어, 저장소, 하이퍼바이저 기술에 따라 달라짐.

'프로그래밍 > 잡다한 꿀팁' 카테고리의 다른 글

| WebStrom과 AWS연동 (0) | 2017.04.05 |

|---|---|

| 더미 텍스트( dummy text) 만들기 - Lorem (0) | 2017.03.07 |

| 안드로이드 오류 : Error:Execution failed for task ':app:transformClassesWithJarMergingForDebug'. 와 같은 오류가 뜰때 (0) | 2016.09.27 |

| Aptana Studio 설치 오류 - Failed to correctly acquire installer node js windows.msi file CRC error (1) | 2016.08.10 |

| ERwin 다운/사용법 (1) | 2016.07.02 |